Sommaire

Nostalgie

Mon premier ordinateur fut un ZX81. C'était un ordinateur familial équipé d'un processeur Z80A cadencé à 3,25Mhz, gérant lui-même la vidéo et équipé d'un kilo-octets de mémoire. On pouvait lui clipser au dos une extension mémoire de 16Ko plus grosse qu'une boîte d'allumettes, qui sautait dès que l'on appuyait trop fort sur les touches et qu'il fallait scotcher solidement pour ne pas perdre son travail de longues heures de recopie des programmes d'hebdogiciel…

À la même époque il y avait aussi l'Oric Atmos, le ZX Spectrum, les MSX, l'Atari ST et l'Amiga et ce bon vieux TO8 avec son processeur 6809E de motorola tournant à 1 Mhz. Quelle folie ! C'était le bon temps ! Tout était possible, et chacun rivalisait de génie pour exhiber les performances de sa machine dans des démos parties où tout se codait en assembleur !

Hélas ils n'ont pas résisté à la venue de l'espèce dominante, les 8086 qui a exterminé tous ces petits mammifères en moins d'une décennie seulement. Et le mastodonte a grossi et connu plus de mutations génétiques que les pokémons d'évolutions : 286, 386, 486, 586 ou Pentium. Puis il est passé d'un code génétique 32bits et d'une architecture CISC à un code 64bits et une architecture mi CISC/RISC tout en se mutant en un animal à plusieurs têtes/cerveaux pour devenir un processeur multicores/multithreads et enfin arriver à son stade actuel de l'évolution le i, actuellement i7 3000, avec 6 cœurs de 2 threads chacun.

Pour en revenir au ZX81 et tous ses amis, c'est intéressant d'observer la puissance de calcul gagnée depuis cette époque glorieuse. Quand j'ai fait mon stage universitaire en 1992, un de mes camarades venait d’acheter un 286 tournant à 16Mhz, équipé de 2Mo de RAM et 200 Mo de disque dur. J'utilisais encore mon TO8 et me suis exclamé ahuri « Mais que vas-tu faire de toute cette puissance ?! »

Aujourd'hui nous serions bien en peine d'installer un OS récent sur une telle machine… En 30 ans l'évolution informatique a été fulgurante :

- La fréquence des processeurs a grimpé d'un facteur mille, pour passer du Mega au Giga Hertz.

- La mémoire vive se mesure aujourd'hui en Giga octets, comparée aux kilos octets de l'époque, le facteur de multiplication des performances est de l'ordre du million.

- Les capacités de stockages sont passées du kilo-octet (K7, disquette) au Tera octets, soit un facteur d'un milliard de fois plus grand.

- Les processeurs sont maintenant multicœurs et multithreads, 2, 4, 8, 16, 32 et maintenant 256 avec les processeurs Kalray.

Si l'on part sur une moyenne de 4 cycles par instruction pour un processeur à 4Mhz, nous avions dans les années 80 une puissance d'environ 1 MIPS pour nos ordinateurs familiaux. C'était déjà pas mal. Bien sûr je parle d'instructions machine, pas de flop, là ce devait être bien moindre.

Le MPPA-256 de Kalray c'est aujourd'hui plus de 460 milliards d'opérations par seconde (MIPS) et 230 Gflops (simple précision), 256 cœurs VLIW (à longues instructions), organisés en 16 clusters de 16 cœurs, supportant jusqu'à 128 Go de RAM et une consommation moyenne de 5W. Pour comparaison un intel i7-980X a une performance d'environ 90 Gflops pour une consommation de 130W.

C'est impressionnant, c'en est même renversant!

Sur le papier le MPPA 256 c'est

- Une consommation 10 fois moindre que les processeurs multicore classiques (un Intel core i7 consomme typiquement 130 Watt)

- Une puissance de calcul 4 fois supérieure à la meilleure puce d'Intel (L'itanium ou le i7-980X)

- Un temps de développement 3 fois plus court que pour les systèmes ASIC ou FPGA (par l'utilisation de langage standard comme C ou C++ et des API de type POSIX)

Mais entre le discours commercial et la réalité, il y a souvent des marches importantes. Rappelez-vous du processeur Crusoé de Transmeta qui annonçait de fabuleuses performances à basse consommation mais qui s'est avéré au final être très en dessous du discours marketing. Mais l'histoire de Transmeta est un peu plus compliquée que cela, nous y reviendrons plus tard.

Dans la pratique le MPPA 256, c'est

- Parfois un peu moins bien

- Parfois beaucoup mieux

En fait tout dépend du contexte d'utilisation. Le processeur KALRAY s'illustre dans tous les domaines utilisant des algorithmes massivement parallélisables :

- Le chiffrement, la cryptographie

- La vidéo

- L'imagerie

- Le traitement du signal

- Le cloud computing/data management

- Les supercalculateurs/HPC

- Le contrôle industriel

- …

Bien qu'il offre une force de calcul impressionnante avec ses 230GFlops, il ne détrône pas les leaders du marché dans ce domaine comme le Xeon X2650. Si vous cherchez la force de calcul brute ce n'est pas forcément le meilleur choix. Mais là où il excelle c'est dans le rapport performances/consommation électrique ou il envoie du lourd, du très très lourd !

Des faits ! Des faits ! Avec des chiffres !

Voilà, voilà, ils arrivent.

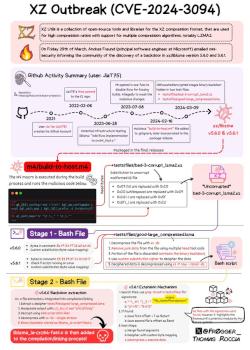

L'encodage vidéo

Qu'il est loin le temps ou l'on mettait des heures à télécharger des vidéos en 320x200 sur le web avec son modem 56k. Aujourd'hui la vidéo est partout sur Internet (WebTV, Streaming, publicité, …). Les formats ont évolué et les vidéos en HD deviennent le standard du moment. Les algorithmes d'encodage se prêtent particulièrement bien à la parallélisation. Les tests d'encodage de vidéos du MPPA 256 sont particulièrement éloquents : A performances égales avec une puce itanium sur l'encodage de vidéos au format HEVC la consommation électrique est 20 fois moindre ! C'est Youtube et Dailymotion qui vont être contents !

L'imagerie et le traitement du signal

Les algorithmes de traitement de l'image ou du signal, utilisant notamment des transformées de Fourier se prêtent eux aussi particulièrement bien à la parallélisation. Les secteurs de la surveillance vidéo, du contrôle de qualité, de l'imagerie médicale, de la géo-physique et bien d'autres sont particulièrement concernés par ces problématiques.

Dans le cadre de l'imagerie médicale, les cas d'études réalisés montrent qu'en remplaçant des processeurs graphiques ou des multi-coeurs massifs par le MPPA-256, un gain d'un facteur 4 en consommation énergétique était obtenu. Cette avancée permet de développer des appareils médicaux mobiles pouvant être embarqués dans des véhicules alors que ces moyens de diagnostic n'étaient disponibles que dans des cabinets de médecins spécialisés.

Le cloud computing, le big data et les fermes de serveurs

Avec l'avènement des sites à volumétrie gigantesque (Google, Yahoo, Amazon, Facebook, Twitter, LinkedIn, Dailymotion, eBay, Wikipedia…) est né le bigdata et le cloud computing ; quant aux fermes de serveurs, elles sont devenues gargantuesques.

En 2011 Google possédait un parc de 900 000 serveurs.

Début 2013 OVH a ouvert le plus grand centre de données au monde avec une capacité de 360 000 serveurs.

Le fort degré de parallélisme du MPPA-256 s'adapte très bien à ces environnements, d'une part par la puissance de calcul qu'il offre, d'autre part par les fabuleuses économies réalisées en matière de consommation électrique. Nous y reviendrons dans quelques instants, mais la consommation électrique est selon moi la clef qui fera de ce processeur un KILLER-PROC !

Les performances énergétiques du MPPA sont particulièrement mesurables dans le cadre de systèmes sur une puce (SoC). Dans le cas d'ordinateurs classiques, comme un PC de bureau, remplacer votre processeur par le MPPA-256 ne permettra pas de mesurer un véritable avantage énergétique : il sera masqué par la consommation des autres composants.

Les supercalculateurs

Les supercalculateurs sont toujours plus puissants. Le dernier record date de novembre 2013 le Tianhe-2 équipé de plus de 3 millions de cœurs d'Intel Xeon avec une puissance de calcul de 33,8 PetaFLOPS pour une consommation de 18 MW vraisemblablement.

Les processeurs multicoeurs d'aujourd'hui ont beaucoup de mal à dépasser les 8 cœurs car la complexité de l'unité de ré-ordonnancement des instructions croit avec le carré du nombre de cœurs gérés.

Pour combler cela le processeur Itanium utilise une technologie différente, l'EPIC qui supprime cet ordonnanceur, très adapté à la programmation parallèle, les meilleurs Itanium ne dépassent cependant pas 8 cœurs.

Avec 256 cœurs dans son MPPA, Kalray réalise un véritable tour de force !

Quand on parle de supercalculateurs il y a 2 éléments importants à prendre en compte dans leur conception :

La consommation électrique de l'ensemble et la qualité de la régularité de la puissance de l'alimentation de l'ensemble des machines impliquées.

La distance occupée entre les éléments composant le supercalculateur : l'information ne peut se déplacer plus vite que la lumière. Aussi, si la distance entre les éléments dépasse plusieurs mètres, des temps de latence de l'ordre de la dizaine de nanoseconde peuvent apparaître et atténuer les performances.

Concernant le premier point, le MPPA-256 se positionne particulièrement bien puisqu'il ne consomme que 5 à 10 watts, il va clairement vous faire économiser des Watts !

Concernant le second point, si l'on caricature la puissance d'un superordinateur à son nombre de cœurs, avec 256 cœurs sur une même puce, à nombre de cœurs égaux, une seule puce MPPA suffit là où il faudrait 32 processeurs 8 cœurs. On diminue donc la taille du système par 32 et d'autant les risques de latence. Enfin, cela reste une caricature, mais c'est un facteur qui a une réelle importance.

Au dernier salon su SuperComputing qui s'est déroulé à DENVER (SC13) KALRAY a démontré une efficacité energétique de 25GFLOPs/W sur des exemples de calcul intensif type multiplication de matrice ou FFT.

Si on compare ses performances au TOP GREEN 500 des supercalculateurs, autrement dit, au top 500 des supercalculateurs ayant le meilleur ratio Flops/W, la tête d'affiche est tenue par le TSUBAME-KFC de l'institut de technologie de Tokyo avec 4,5 Gflop/Watt.

Avec 25 Gflop/Watt, le MPPA 256 de Kalray battrait d'un facteur 5 ce dernier. Autrement dit, à consommation égale il aurait une force de calcul 5 fois supérieure, ou à puissance égale il consommerait 5 fois moins… Cela laisse rêveur.

Pourquoi Kalray peut réussir là où Transmeta a échoué

Aujourd'hui l'énergie est un véritable enjeu économique et environnemental. Nous en consommons de plus en plus et elle coûte de plus en plus cher, quelle que soit sa forme : électricité, carburant, gaz, …

Elle est l'objet d'une guerre économique, de défis scientifiques et de problèmes politiques.

Du côté de l'informatique nous ne sommes pas épargnés par ce besoin : « les TIC pèsent, avec 1 500 teraWatt-heure d'électricité consommée par an, pour 10 % de la production mondiale. Soit la production de l'Allemagne et du Japon ».

Ce problème se constate aujourd'hui facilement chez les prestataires disposant d'énormes fermes de serveurs :

Avec une consommation réduite d'un facteur 10 sur les architectures classiques, le processeur Kalray vient clairement bouleverser le jeu et offre une solution particulièrement à propos concernant un besoin de plus en plus crucial pour ce type d'entreprises. L'ignorer serait économiquement dangereux.

Vous allez me dire, « ok », sur la consommation électrique il décoiffe, mais pourquoi réussirait-il là où Transmeta a échoué ?

Transmeta a échoué pour, à mon humble avis, ces 3 raisons principales :

Kalray n'a pas ces problèmes :

Le processeur déchire grave de la mort qui tue en termes de performances et surtout de ratio performances/consommation énergétique

Kalray a une architecture sans complexité ajoutée : le processeur n'essaye pas d'émuler les x86 et fonctionne avec son propre jeu d'instructions, en natif. La chaîne de compilation MPPA ACCESSCORE de KALRAY permet de porter et exécuter efficacement une application écrite en C sur l'architecture MPPA MANYCORE. Tout programmeur préfère rester au niveau C et ne pas se plonger dans l’écriture en assembleur spécifique à un processeur.

Le marché est carrément mûr. Au début des années 2000, Jean-Louis Gassée, fondateur de BeOS, disait que l'avenir était dans les applications de type « internet Appliance », ce qui l'avait même amené à renommer son OS en BeIA. Aujourd'hui nous observons qu'il avait clairement raison. Nous retrouvons ce type d'applications connectées un peu partout : dans les voitures, dans votre frigo, dans votre téléphone… Ces applications souvent embarquées nécessitent souvent des consommations réduites. Enfin, les problèmes de consommation et d'alimentation électrique des grands centres de données n'ont jamais été si importants et problématiques qu'aujourd'hui.

Les processeurs Kalray répondent parfaitement au double problème énergétique des grands centres de données, à savoir la fin de la course à l'optimisation de l'infrastructure (PUE en anglais Power Usage Effectiveness ). Les grands centres de calcul optimisés ont atteint un PUE proche de 1.15 grâce aux efforts visant à réduire toute la consommation électrique « périphérique » comme la chaîne de conversion depuis la haute tension, la climatisation et le refroidissement.

De plus, étant à la limite de la puissance énergétique que les fournisseurs d’électricité peuvent délivrer, l'économie d’énergie va devoir maintenant s'attaquer au cœur du problème : l'efficacité énergétique des nœuds de calcul eux-mêmes.

En demeurant avec l'architecture constante basée sur x86, la loi de Moore implique une multiplication par 2 tous les 2 ans de la performance et donc de la consommation électrique. Or, les plus grands centres de données consomment près de 18MW aujourd'hui et sont dans l'incapacité d'augmenter la capacité de leur lignes électriques.

La solution MPPA de KALRAY apporte une réponse commune à ces deux événements combinés rencontrés dans le monde des supercalculateurs avec une efficacité énergétique 10 fois supérieure à ce qui ce fait de mieux aujourd'hui.

Enfin, Kalray tourne sur Linux. Il possède tous les atouts pour séduire les constructeurs de supercalculateurs et les exploitants des fermes de serveurs. Une version 64 cœurs encore plus économe pourrait aussi faire fonctionner un smartphone, c'est une voie qui reste à exploiter par KALRAY.

Bien que la société ne fasse pas encore beaucoup parler d'elle, contrairement à Transmeta qui a su lancer un énorme Buzz avant d'afficher son produit, elle bénéficie déjà de nombreux partenariats avec des industriels dans de nombreux domaines (aéronautique, automobile, recherche, audiovisuel, industrie, …).

Parmi ceux-ci nous pouvons citer Renault, Thales, Digigram, Inria, Ateme, …

Les projets menés avec ces industriels lui permettent actuellement de valider les capacités de son processeur avant un lancement en fanfare et surtout lui assurent les premiers revenus pour développer ce qui pourrait bien s'avérer être le prochain processeur de la décennie à venir.

En informatique rien n'est jamais acquis. Beaucoup pensaient que Microsoft et Intel domineraient éternellement le monde de la micro-informatique, mais Microsoft a clairement manqué la marche des smartphones au profit d'Apple et de Google, ce qui quelque part, fait la belle part à Linux.

Intel a su mieux réagir sur ce marché mais s'est quand même bien fait damer le pion par ARM.

Pourtant ARM a longtemps vécu dans l'ombre d'Intel et AMD en fonctionnant essentiellement sur les systèmes embarqués nécessitant une faible consommation électrique.

C'est clairement cette course énergétique qui a conféré à cette société le succès qu'elle connaît aujourd'hui avec les appareils mobiles. C'est cette même quête de l'énergie qui a toutes les chances de faire décoller les processeurs MPPA de Kalray.

Les risques

Mais rien n'est jamais acquis et la vie n'est jamais toute rose pour personne :

Kalray doit encore séduire les constructeurs et industriels. Les évaluations en cours devraient continuer de confirmer ses bonnes performances.

Kalray reste jeune, et même s'il sait faire tourner Linux, il ne fait pas encore tourner de distributions comme Debian ou Ubuntu. Pour gagner le cœur des providers Internet, ce dernier point doit être résolu. Mais cela ne devrait pas longtemps être un obstacle avec l'arrivée de Marta Rybczynska dans leur équipe, laquelle termine d'amener Linux sur la voie des processeurs massivement parallèles.

Il ne suffit pas d'avoir le plus beau pédigree pour réussir. BeOS et NextStep n'ont pas su survivre aux licences EULA et à l'agressivité Marketing de Microsoft. AMD n'a jamais réussi à vraiment tenir tête à Intel, même s'il a su survivre jusqu'ici, la société est très mal portante.

Alors, pourquoi Kalray pourrait vraiment réussir ?

Parce que l’efficacité énergétique de ce nouveau processeur amène une réelle rupture technologique qui trouvera un double écho dans le monde des grands centres de données qui sont dans le mur énergétique aujourd'hui et dans le monde de l'embarqué car il rend des applications réalisables aujourd'hui qui étaient impossibles auparavant, demandant une forte puissance de calcul pour un budget consommation restreint.

Lorsque des centres comme ceux d'OVH ou Google auront compris qu'avec cette puce ils pourront avoir 10 fois plus de machines à consommation égale ou consommer 10 fois moins pour la même puissance de calcul, leurs calculs seront vite faits : « Business is money ! »

Les processeurs MPPA 256 sont aussi et avant tout une alternative aux solutions FPGA et ASICS actuellement utilisées dans les projets industriels ayant besoin d'une grande puissance de calcul. Ils diminuent la complexité de programmation de ce type de puces qui demandent plusieurs mois de développement en ramenant ce délai à quelques semaines : « Time is money ! »

Les processeurs Kalray tiennent apparemment clairement leurs engagements et aucun autre processeur du marché ne rivalise aujourd'hui avec leur rendement en terme de puissance/consommation électrique. Et contrairement aux projets en cours de leurs concurrents, les MPPA 256 sont opérationnels et disponibles dès maintenant sur le marché.

Ceux qui les utiliseront massivement économiseront massivement leur argent, et dans des marchés hautement concurrentiels, l'argent fait loi. Ailleurs aussi d'ailleurs. Mais là, carrément.

Question force de production, Kalray a sous-traité la fabrication de ses processeurs au numéro un mondial TSMC. Les problèmes d'approvisionnement ne devraient pas se présenter.

Enfin, la société n'en est qu'à ses débuts et planche déjà sur un MPPA à 1024 cœurs après l'avoir déjà démontré au dernier SuperComputing show à Denver en Novembre 2013.(kalray-today-announces-world-s-first-hyper-scalable-1000-cores-mimd-processor). De quoi durer face à la concurrence et aux besoins toujours croissants en puissance de calcul de nos chers ingénieurs.

Et l'ordinateur du futur…

Pour ceux qui comme moi rêvent un peu trop à voix haute et s'intéressent aux avancées de la science et de l'industrie, voyez ce que le futur nous prépare :

Tout d'abord, dans un futur presque immédiat nous devrions voir la fusion des systèmes hôtes smartphone/tablettes et ordinateurs portables à l'instar du Padfone d'Asus ou des nouveaux portables dont l'écran se détache comme celui d'une tablette.

Tous les ordinateurs auront donc au moins une carte SIM intégrée avec le support 4G et du coup la fibre optique se généralisera pour tenter de concurrencer la 4G. Nostradamus a parlé. Mais cela, c'est déjà en cours.

Bien sur ces ordinateurs seront entièrement personnalisables sur le principe du Phonebloks.

Tous les écrans seront tactiles et même pliables comme des feuilles de papier.

Les batteries de nos téléphones seront produites par des bactéries en impression 3D. Ils seront d'ailleurs équipés d'un mini panneau photovoltaïque ayant un rendement important et leur conférant une autonomie quasi illimitée.

Ils seront équipés de détecteurs en tout genre comme la radioactivité, le cancer, microscope, laser…

Ils pourront être pilotés par télépathie et nous transmettre des informations sensorielles.

Bien sur ils se localiseront grâce au système Galiléo avec une précision inférieure au millimètre. Sisi, il va arriver, un jour…

Ils n'utiliseront plus le silicium mais des composés carbonés comme le graphène. Et stockeront des petas octets de données dans des mémoires à base de quartz…

Et ils seront quantiques…

Pour finir, ils auront des verres incassables de chez Afflelou ou tomberont toujours du bon côté.

Pour finir, je tiens à préciser que, malgré mon engouement notoire pour cette belle technologie qu'est le MPPA 256, je ne travaille pas pour Kalray. Ce qui n'empêche pas que je sois totalement partial sur ce sujet. Normal, le MPPA 256 c'est un catalyseur d'économies : c'est bon pour le business, et c'est bon pour la planète !