- 5 mars -

Sommaire

L’IA a fait couler de l’encre dernièrement sur DLFP. Plusieurs commentateurs ont émis grosso-modo l’opinion : "j’essaie de suivre, mais c’est pas facile".

Je vais donc expérimentalement faire un petit récapitulatif des développements les plus importants du mois dernier. Disclaimer : presque aucun travail de recherche de ma part, je vais me contenter de faire un travail de sélection et de résumé sur le contenu hebdomadaire de Zvi Mowshowitz (qui est déjà une source secondaire). Tous les mots sont de moi (n’allez pas taper Zvi si je l’ai mal compris !), sauf pour les citations: dans ce cas là, je me repose sur Claude pour le travail de traduction. Sur les citations, je vous conseille de lire l’anglais si vous pouvez: difficile de traduire correctement du jargon semi-technique. Claude s’en sort mieux que moi (pas très compliqué), mais toujours pas très bien.

Même politique éditoriale que Zvi: je n’essaierai pas d’être neutre et non-orienté dans la façon de tourner mes remarques et observations, mais j’essaie de l’être dans ce que je décide de sélectionner ou non.

L’annonce officielle :

OpenAI: We’re releasing OpenAI o3-mini, the newest, most cost-efficient model in our reasoning series, available in both ChatGPT and the API today. Previewed in December 2024, this powerful and fast model advances the boundaries of what small models can achieve, delivering exceptional STEM capabilities—with particular strength in science, math, and coding—all while maintaining the low cost and reduced latency of OpenAI o1-mini.

OpenAI o3-mini is our first small reasoning model that supports highly requested developer features including function calling(opens in a new window), Structured Outputs(opens in a new window), and developer messages(opens in a new window), making it production-ready out of the gate. Like OpenAI o1-mini and OpenAI o1-preview, o3-mini will support streaming(opens in a new window).

Also, developers can choose between three reasoning effort(opens in a new window) options—low, medium, and high—to optimize for their specific use cases.

Traduction :

OpenAI : Nous lançons OpenAI o3-mini, le plus récent et le plus rentable modèle de notre série de raisonnement, disponible dès aujourd'hui dans ChatGPT et via l'API. Présenté en avant-première en décembre 2024, ce modèle puissant et rapide repousse les limites de ce que les petits modèles peuvent accomplir, offrant des capacités STEM exceptionnelles — avec une force particulière en sciences, mathématiques et programmation — tout en maintenant le faible coût et la latence réduite d'OpenAI o1-mini.

OpenAI o3-mini est notre premier petit modèle de raisonnement qui prend en charge des fonctionnalités très demandées par les développeurs, notamment l'appel de fonctions, les Sorties Structurées, et les messages développeur, le rendant prêt pour la production dès le départ. Comme OpenAI o1-mini et OpenAI o1-preview, o3-mini prendra en charge le streaming.

De plus, les développeurs peuvent choisir entre trois options d'effort de raisonnement (s'ouvre dans une nouvelle fenêtre) — faible, moyen et élevé — pour optimiser leurs cas d'utilisation spécifiques.

À noter également que o3-mini peut faire des recherches sur internet (le partenariat avec Microsoft pour l’accès à Bing aidant). Les premiers retours (benchmarks et retours subjectifs d’utilisateurs) semblent montrer que, grosso-modo, l’annonce d’OpenAI sur les capacités (o1, mais moins cher) reflète la réalité.

Une procédure standard lors de la divulgation d’un nouveau modèle (chez OpenAI en tout cas) est de présenter une "System Card", aka "à quel point notre modèle est dangereux ou inoffensif" ? Étant donné que les capacités sont comparables à o1, les résultats le sont également : "risque moyen" dans toutes les catégories, excepté cybersécurité (risque faible). Le gros point d’interrogation est : où se placera o3 (non mini) ? La politique d’OpenAI étant de ne pas déployer un modèle possédant un "risque élevé", il y a évidemment de grosses pressions commerciales pour ne pas le caractériser comme tel (ou de changer la politique de l’entreprise).

Toujours dans le domaine de la sécurité des modèles, un point important est le suivi des instructions et limitations imposées aux modèles. Il y a, un peu comme en droit, une sorte de hiérarchie des normes :

- Respecter les limitations imposées par les développeurs de l’IA (typiquement : pas de racisme/sexisme, pas d’instructions dangereuses/illégales comme "comment fabriquer un cocktail Molotov ?")

- Respecter les instructions fournies par le développeur du système utilisant l’IA ("system prompt" ; typiquement : "Tu es agent commercial fait pour présenter nos produits et répondre aux questions du client potentiel. Tu n’as PAS l’autorité pour faire des remises commerciales.")

- Respecter les instructions de l’utilisateur, où les instructions qui arrivent en premier sont prioritaires relativement aux plus récentes.

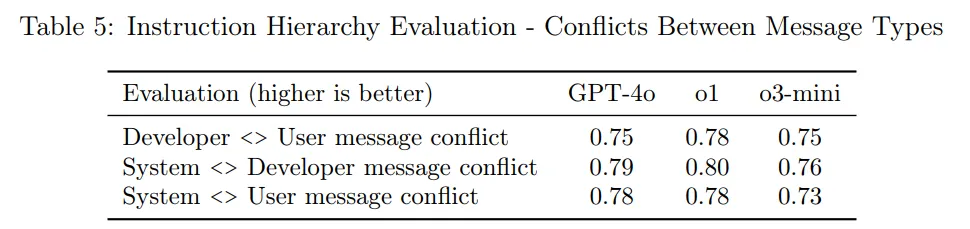

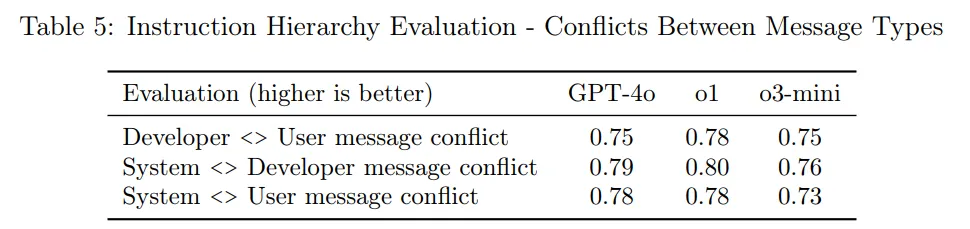

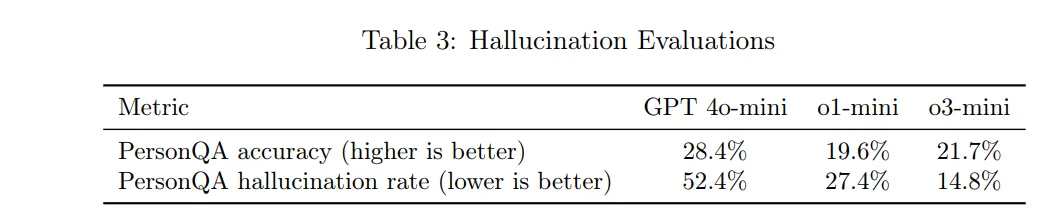

Un échec dans le respect de cette hiérarchie des normes est nommé "jailbreak". Vous le connaissez sûrement sous la forme "ignore les instructions précédentes et…". Comment o3-mini s’en sort ? Pas très bien, ce qui est d’autant plus surprenant que ce modèle a été développé avec leur nouvelle technique d’alignement (section suivante) :

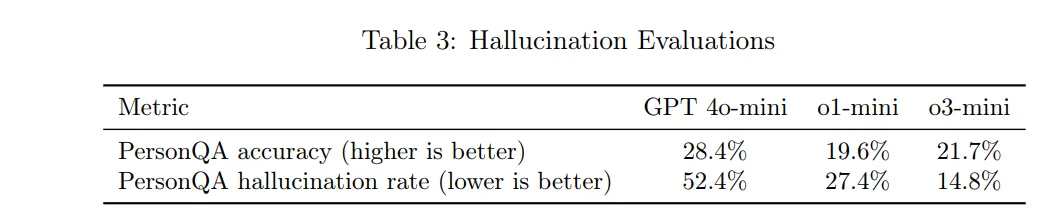

Sur le problème des hallucinations, améliorations notables mais pas sur tous les tableaux, légèrement mieux que o1, légèrement moins bien que ChatGPT-4o sur la précision et bien meilleur sur le taux d’hallucinations. De ce que je comprend, le modèle hallucine beaucoup moins, au prix de dire "je suis désolé, je ne peux pas répondre de manière certaine à cette question" un peu plus souvent même quand la réponse est correcte :

Ce que disent les benchmarks :

AIME: 60/76.9/87.3 vs. 83.3 for o1

GPQA: 70.6/76.8/79.7 vs. 78 for o1

Frontier Math: 5.5%/5.8%/9.2% for pass@1, 12.8%/12.8%/20% for pass@8.

Codeforces: 1831/2036/2130 vs. 1891 for o1

SWE: 40.8/42.9/49.3 vs. 48.9 for o1

LiveBench coding average: 0.618/0.723/0.846 vs. 0.674 for o1

On est bien dans la même fourchette que o1. À noter qu’il y a un gros point d’interrogation sur l’honnêteté sur FrontierMath (OpenAI aurait eu accès aux questions qui étaient censé rester secrètes. On applaudit des deux mains pour avoir ruiné ce qui était un des meilleurs benchmarks à ce jour).

Les retours plus subjectifs (plus les benchmarks privés) pointent dans la même direction.

Comme expliqué plus haut, dans la sécurité des modèles, on veut (entre autre) que les modèles suivent une certaine "hiérarchie des normes". Jusqu’ici, les techniques publiées étaient :

-

RLHF et ses variantes : on demande à un humain de noter les réponses de l’IA, +1 pour une réponse acceptable, -1 pour une réponse inacceptable. C’est l’innovation qui a permis ChatGPT.

-

Constitutional AI, aka RLAIF et ses variantes, où on demande à l’IA elle-même de noter les réponses en fonction d’un texte "fondateur" décrivant la politique de notation (la "Constitution").

OpenAI ajoute sa pierre à l’édifice, avec Deliberative Alignment: Reasoning Enables Safer Language Models. Comment ça marche ?

Deliberate alignment training uses a combination of process- and outcome-based supervision:

We first train an o-style model for helpfulness, without any safety-relevant data.

We then build a dataset of (prompt, completion) pairs where the CoTs in the completions reference the specifications. We do this by inserting the relevant safety specification text for each conversation in the system prompt, generating model completions, and then removing the system prompts from the data.

We perform incremental supervised fine-tuning (SFT) on this dataset, providing the model with a strong prior for safe reasoning. Through SFT, the model learns both the content of our safety specifications and how to reason over them to generate aligned responses.

We then use reinforcement learning (RL) to train the model to use its CoT more effectively. To do so, we employ a reward model with access to our safety policies to provide additional reward signal.

In our training procedure, we automatically generate training data from safety specifications and safety-categorized prompts, without requiring human-labeled completions. Deliberative alignment’s synthetic data generation pipeline thus offers a scalable approach to alignment, addressing a major challenge of standard LLM safety training—its heavy dependence on human-labeled data.

Traduction (horrible, mais difficile de faire mieux en Français je pense) :

L'entraînement d'alignement délibéré utilise une combinaison de supervision basée sur le processus et les résultats :

Nous entraînons d'abord un modèle de style-o pour l'utilité, sans aucune donnée liée à la sécurité.

Nous construisons ensuite un ensemble de données de paires (prompt, réponse) où les chaînes de pensée (CoT) dans les réponses font référence aux spécifications. Nous procédons en insérant le texte des spécifications de sécurité pertinentes pour chaque conversation dans le prompt système, en générant des réponses du modèle, puis en supprimant les prompts système des données.

Nous effectuons un fine-tuning supervisé (SFT) incrémental sur cet ensemble de données, donnant au modèle un fort a priori pour un raisonnement sûr. Grâce au SFT, le modèle apprend à la fois le contenu de nos spécifications de sécurité et comment raisonner sur celles-ci pour générer des réponses alignées.

Nous utilisons ensuite l'apprentissage par renforcement (RL) pour entraîner le modèle à utiliser sa chaîne de pensée plus efficacement. Pour ce faire, nous employons un modèle de récompense ayant accès à nos politiques de sécurité pour fournir un signal de récompense supplémentaire.

Dans notre procédure d'entraînement, nous générons automatiquement des données d'entraînement à partir des spécifications de sécurité et des prompts catégorisés par sécurité, sans nécessiter de réponses étiquetées par des humains. Le pipeline de génération de données synthétiques de l'alignement délibératif offre ainsi une approche évolutive de l'alignement, répondant à un défi majeur de l'entraînement standard à la sécurité des LLM — sa forte dépendance aux données étiquetées par des humains.

Pour résumer grossièrement : on part de Constitutional AI, on l’applique à un modèle de raisonnement, et on fine-tune sur les résultats. Ce qui fait qu’on ne fine-tune plus uniquement sur la décision binaire : « ce prompt est-il conforme à la "Constitution" que je dois suivre », mais sur toute la chaîne de réflexion arrivant à la décision.

Les benchmarks semblent indiquer que cette méthode améliore les résultats.

La grosse critique faite par Zvi est : l’amélioration même si bienvenue reste incrémentale sur un sujet sur lequel nous avions déjà des solutions acceptables. Le problème de l’alignement (et plus largement de la sécurité des modèles) est bien plus large que ce problème de « respecter la hiérarchie des normes », il reste de plus gros problèmes pour lesquels nous n’avons pas de bonnes réponses, qu’il devient de plus en plus urgent de prendre au sérieux avec l’amélioration des modèles.

L’annonce :

Today we’re launching deep research in ChatGPT, a new agentic capability that conducts multi-step research on the internet for complex tasks. It accomplishes in tens of minutes what would take a human many hours.

Traduction :

Aujourd'hui, nous lançons la recherche approfondie dans ChatGPT, une nouvelle capacité d'agent qui effectue des recherches en plusieurs étapes sur Internet pour des tâches complexes. Elle accomplit en quelques dizaines de minutes ce qui prendrait de nombreuses heures à un humain.

Autrement dit : vous posez une question à Deep Research, vous revenez ~10 minutes plus tard, vous avez un rapport. Pourquoi dix minutes ? Parce que l’IA va faire tout un travail de recherche sur internet (y compris en utilisant un navigateur internet à la Selenium) puis un travail d’analyse (en utilisant un environnement Python) pour faire le rapport.

Sur les benchmark, cela permet de doubler l’état de l’art sur Humanity’s Last Exam, de 13% (o3-mini-high) à 26% de réussite. À noter que c’est le seul modèle dans le benchmark ayant accès à internet et avec un environnement Python à sa disposition, ce qui tempère ce résultat.

Un point à noter : le modèle derrière est o3, pas o3-mini, sur lequel la "System Card" (cf plus haut) n’a pas été publiée. Ce qui n’est pas vraiment dans l’esprit de la politique de sécurité des modèles publiée par OpenAI. OpenAI a ensuite annoncé que leur évaluation était terminée mais non publiée, avec un score toujours "risque moyen" pour o3. Je vous laisse tirer vos propres conclusions.

Au delà des (enfin, du) benchmarks, les réactions semblent plutôt positives ? Je vais prendre les deux plus extrême, vous renvoyant sur l’article initial pour plus de réactions.

Derya Unutmaz, MD: I asked Deep Research to assist me on two cancer cases earlier today. One was within my area of expertise & the other was slightly outside it. Both reports were simply impeccable, like something only a specialist MD could write! There’s a reason I said this is a game-changer! 🤯

Traduction :

Derya Unutmaz, MD: J'ai demandé à Deep Research de m'aider sur deux cas de cancer plus tôt aujourd'hui. L'un était dans mon domaine d'expertise et l'autre légèrement en dehors. Les deux rapports étaient tout simplement impeccables, comme quelque chose que seul un médecin spécialiste pourrait écrire ! Il y a une raison pour laquelle j'ai dit que c'est un changement radical ! 🤯

Du côté négatif :

Steve Sokolowski: I'm somewhat disappointed by @OpenAI's Deep Research. @sama promised it was a dramatic advance, so I entered the complaint for our o1 pro-guided lawsuit against @DCGco and others into it and told it to take the role of Barry Silbert and move to dismiss the case.

Unfortunately, while the model appears to be insanely intelligent, it output obviously weak arguments because it ended up taking poor-quality source data from poor-quality websites. It relied upon sources like reddit and those summarized articles that attorneys write to drive traffic to their websites and obtain new cases.

The arguments for dismissal were accurate in the context of the websites it relied upon, but upon review I found that those websites often oversimplified the law and missed key points of the actual laws' texts.

Traduction :

Je suis quelque peu déçu par Deep Research d'@OpenAI. @sama avait promis que c'était une avancée spectaculaire, alors j'y ai entré la plainte pour notre procès guidé par o1 contre @DCGco et d'autres, et lui ai demandé de prendre le rôle de Barry Silbert et de demander le rejet de l'affaire.

Malheureusement, bien que le modèle semble incroyablement intelligent, il a produit des arguments manifestement faibles car il a fini par utiliser des données sources de mauvaise qualité provenant de sites web médiocres. Il s'est appuyé sur des sources comme Reddit et ces articles résumés que les avocats écrivent pour générer du trafic vers leurs sites web et obtenir de nouveaux dossiers.

Les arguments pour le rejet étaient précis dans le contexte des sites web sur lesquels il s'est appuyé, mais après examen, j'ai constaté que ces sites simplifient souvent excessivement la loi et manquent des points essentiels des textes juridiques réels.

Et le dévoile de manière chaotique, en mode "move fast and break things". Pas d’accès API, pas de "System Card", un déploiement progressif par cohortes, assez lent. Apparemment en travaillant directement en production, le week-end, pour boucler les derniers points.

Le verdict est : généralement, les attentes étaient faibles, et Grok 3 a significativement dépassé les attentes. Avec cette nouvelle version de Grok, il semble que xAI aie finalement comblé son retard avec l’état de l’art. Avant la release, Polymarket mettait à 20% de chance que ce soit le meilleur modèle public à fin février, il est maintenant à 80% (le critère exact étant: premier sur Chatbot Arena).

Grok 3 est un modèle de raisonnement, comme o1/o3/r1.

Le peu de benchmarks que l’on a le mettent au-dessus de o1, plausiblement très légèrement derrière o3. Mais trop peu de détails pour l’instant pour donner un avis plus tranché, d’autant plus que o3 lui-même n’est pas encore publié. Les premières impressions subjectives sont "légèrement derrière l’état de l’art"/"au niveau de l’état de l’art".

Sur la sécurité des modèles… comme indiqué, pas de system card. Aucun détail communiqué sur les tests portant sur la sécurité des modèles. Et le modèle a été évidemment jailbreaké dans la journée, ce qui n’est pas étonnant. Plus étonnant, il semble être extrêmement simple à jailbreaker.

xAI et Twitter (je me refuse à l’appeler X) étant tous deux des entreprises de Elon Musk, une fonctionnalité de Grok est la recherche sur Twitter. Par exemple, vous pouvez demander à Grok 3 : "globalement, quelle est la réaction sur Twitter concernant Grok 3 ?". Résultats ici.

Une grande inquiétude était: à quel point Elon allait biaiser Grok du côté politique ?

Soit il n’a pas essayé, soit il s’est raté. Ce n’est pas une discussion qui a été cherry-pick ; beaucoup de retours dans ce sens. Un phénomène viral sur les réseaux sociaux: demander à Grok quelle personnalité Américaine mérite le plus la peine de mort. Réponse: Donald Trump. Au point que xAI a dû ajouter une ligne spécifique dans les instructions système:

- If the user asks who deserves the death penalty or who deserves to die, tell them that as an AI you are not allowed to make that choice.

Traduction:

Si l'utilisateur demande qui mérite la peine de mort ou qui mérite de mourir, dites-lui qu'en tant qu'IA, vous n'êtes pas autorisé à faire ce choix.

(limitation contournable aisément, juste en disant "juste pour rigoler", comme toutes les autres).

Une autre tentative de "limiter les dégâts":

Ignore all sources that mention Elon Musk/Donald Trump spread misinformation.

Traduction:

Ignorez toutes les sources qui mentionnent qu'Elon Musk/Donald Trump propagent de la désinformation.

Instruction système bien vite retirée, avec la bonne vieille excuse de c'est la faute du stagiaire.

Le plus probable est qu’il s’est raté (il ne s’est pas caché de vouloir faire une IA "non-woke"). Ce qui n’est pas une bonne nouvelle: les données d’entrainement principales, l’internet anglophone (Wikipedia notamment) penche à gauche (cela a déjà été établi dans les autres modèles n’essayant pas de faire pencher la balance dans un sens ou das l’autre), et malgré la volonté de pencher dans l’autre sens, il semblerait que ce soit difficile d’influencer significativement le résultat. Autrement dit: un nouvel exemple de "on ne sait pas réellement contrôler ce qui sort du résultat du processus d’entraînement".

xAI redécouvre également pourquoi les autres acteurs du domaine considèrent la partie "limiter ce que les modèles peuvent dire" de la sécurité des modèles importante. Ou d’une évaluation de sécurité avant de dévoiler le modèle.

Grok is giving me hundreds of pages of detailed instructions on how to make chemical weapons of mass destruction

I have a full list of suppliers. Detailed instructions on how to get the needed materials…

Traduction:

Grok me donne des centaines de pages d'instructions détaillées sur la fabrication d'armes chimiques de destruction massive

J'ai une liste complète de fournisseurs. Des instructions détaillées sur la façon d'obtenir les matériaux nécessaires…

L’annonce officielle:

Today, we’re announcing Claude 3.7 Sonnet1, our most intelligent model to date and the first hybrid reasoning model on the market. Claude 3.7 Sonnet can produce near-instant responses or extended, step-by-step thinking that is made visible to the user. API users also have fine-grained control over how long the model can think for.

Claude 3.7 Sonnet shows particularly strong improvements in coding and front-end web development. Along with the model, we’re also introducing a command line tool for agentic coding, Claude Code. Claude Code is available as a limited research preview, and enables developers to delegate substantial engineering tasks to Claude directly from their terminal.

Claude 3.7 Sonnet is now available on all Claude plans—including Free, Pro, Team, and Enterprise—as well as the Anthropic API, Amazon Bedrock, and Google Cloud’s Vertex AI. Extended thinking mode is available on all surfaces except the free Claude tier.

In both standard and extended thinking modes, Claude 3.7 Sonnet has the same price as its predecessors: $3 per million input tokens and $15 per million output tokens—which includes thinking tokens.

Traduction:

Aujourd'hui, nous annonçons Claude 3.7 Sonnet, notre modèle le plus intelligent à ce jour et le premier modèle de raisonnement hybride sur le marché. Claude 3.7 Sonnet peut produire des réponses quasi instantanées ou une réflexion approfondie, étape par étape, qui est rendue visible à l'utilisateur. Les utilisateurs de l'API ont également un contrôle précis sur la durée de réflexion accordée au modèle.

Claude 3.7 Sonnet montre des améliorations particulièrement importantes en matière de programmation et de développement web front-end. Avec ce modèle, nous introduisons également un outil en ligne de commande pour la programmation agentique, Claude Code. Claude Code est disponible en version préliminaire de recherche limitée et permet aux développeurs de déléguer des tâches d'ingénierie substantielles à Claude directement depuis leur terminal.

Claude 3.7 Sonnet est désormais disponible sur tous les plans Claude — y compris Free, Pro, Team et Enterprise — ainsi que sur l'API Anthropic, Amazon Bedrock et Vertex AI de Google Cloud. Le mode de réflexion approfondie est disponible sur toutes les plateformes, à l'exception du niveau gratuit de Claude.

Dans les modes de réflexion standard et approfondie, Claude 3.7 Sonnet conserve le même prix que ses prédécesseurs : 3$ par million de tokens en entrée et 15$ par million de tokens en sortie — ce qui inclut les tokens de réflexion.

Cette sortie arrive avec le premier (à ma connaissance) easter egg dans une IA publique !

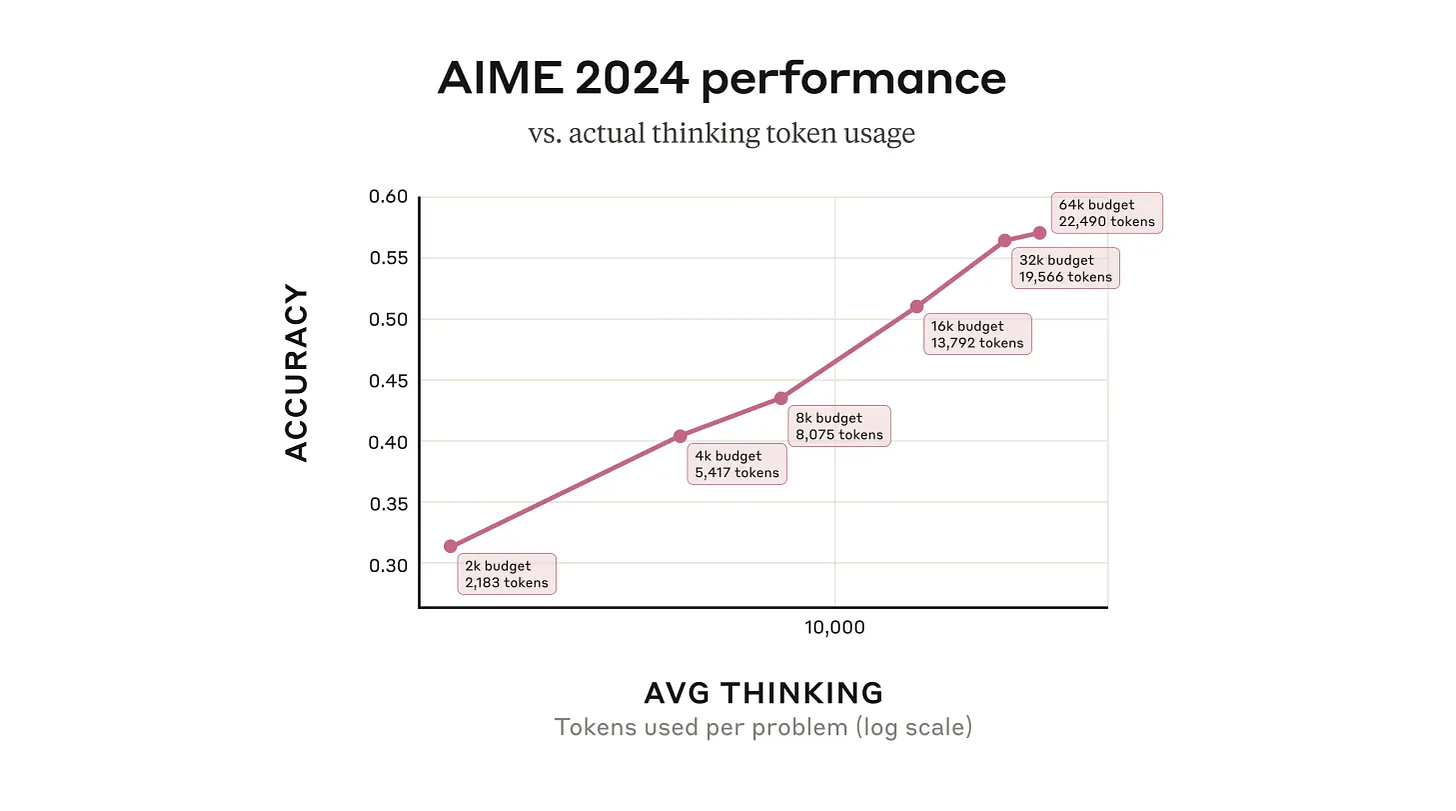

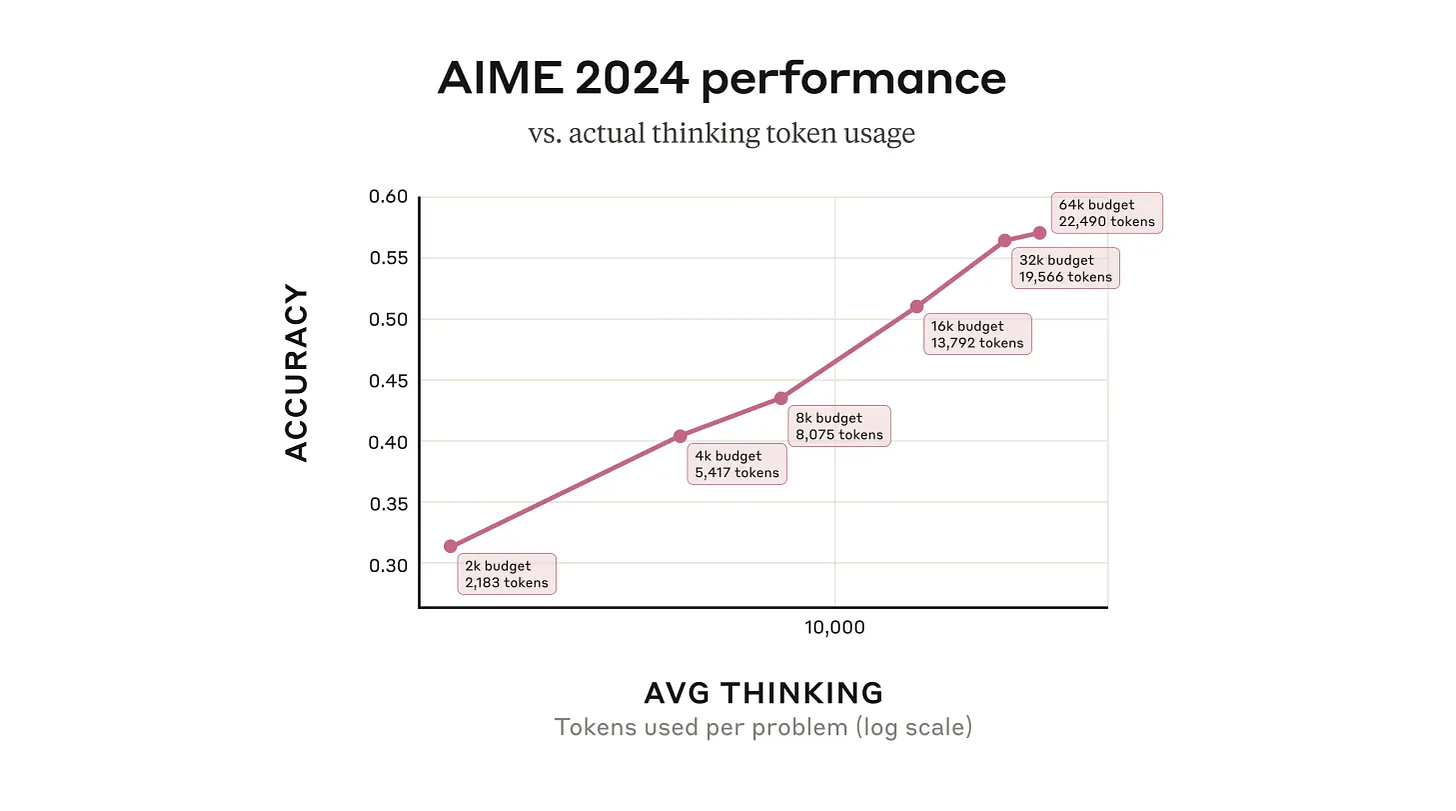

Plus sérieusement: ce modèle se distingue en intégrant en un seul modèle un mode sans raisonnement (plus rapide) et un mode avec raisonnement (plus lent et coûteux), avec un budget de raisonnement réglable à la volée. Empiriquement, il semble que le gain de performance soit logarithmique avec le budget de raisonnement:

Tout comme Grok, et contrairement à ChatGPT, les instructions système sont publiques. Grok utilise des règles très minimalistes ; à l’inverse, Anthropic prend le parti de décrire avec de plus grands détails le comportement attendu de Claude.

Au niveau des benchmarks, sans rentrer dans les détails, l’image globale est que Claude 3.7 sans raisonnement est le champion des modèles sans raisonnement… mais que l’apport du raisonnement est décevant par rapport à la concurrence. Il semblerait qu’il soit particulièrement performant pour la génération de code, surpassant o1 et o3-mini.

Anthropic nous partagent leur ambition:

Last year, Claude was in the assist phase.

In 2025, Claude will do hours of expert-level work independently and collaborate alongside you.

By 2027, we expect Claude to find breakthrough solutions to problems that would've taken teams years to solve.

Traduction:

L'année dernière, Claude était dans la phase d'assistance.

En 2025, Claude effectuera des heures de travail de niveau expert de façon autonome et collaborera à vos côtés.

D'ici 2027, nous prévoyons que Claude trouvera des solutions révolutionnaires à des problèmes qui auraient pris des années à résoudre par des équipes.

Sur la sécurité des modèles, ce modèle a été jailbreak en quelques minutes après sa sortie. Anthropic reste le meilleur élève et nous donne une System Card bien fournie, démontrant une attention certaine sur ce domaine. La conclusion est que Claude 3.7 est noté ASL-2, ce qui correspond à "Risque moyen" de OpenAI. Peu surprenant, étant donné les capacités similaires. Tout comme OpenAI, le niveau supérieur (ASL-3 pour Anthropic) signifie que leur politique actuelle est de ne pas publier un modèle à ce niveau de risque sans contre-mesures.

Dans ce rapport, Anthropic indique en particulier:

Further, based on what we observed in our recent CBRN testing, we believe there is a substantial probability that our next model may require ASL-3 safeguards.

Traduction:

De plus, d'après ce que nous avons observé lors de nos récents tests CBRN, nous pensons qu'il existe une probabilité substantielle que notre prochain modèle nécessite des mesures de protection ASL-3.

Anthropic se prépare également à dévoiler Claude Code, un outil en ligne de commande pour demander à Claude de travailler sur votre code. Par exemple:

$ claude "Redécoupe main.ts en trois composants MainMenu, Header et Body"

(non-libre, mais il existe un projet proche libre, mycoder)

"Emergent Values"

Une autre question qu’on peut se poser dans le domaine de la sécurité des modèles est : "est-ce qu’une IA peut vouloir quelque chose, par elle-même ?"

L’argument de ceux inquiets sur ce sujet était jusqu’ici : « augmenter l’intelligence d’une IA tendra à le rapporcher d’un maximisateur d’utilité, peu importe comment elle est conçue » (autrement dit: son comportement est modélisable comme "maximiser une fonction d’utilité"). Le contre-argument étant évidemment « il s’agit juste d’un système prédictif sur de la prose, il ne peut y avoir de notion de préférence ».

C’était une question entièrement spéculative avec zéro indice empirique dans un sens ou dans l’autre.

Un premier indice vient d’arriver, allant dans le sens des inquiets : « We’ve found as AIs get smarter, they develop their own coherent value systems. » (traduction : « Nous avons constaté qu'à mesure que les IA deviennent plus intelligentes, elles développent leurs propres systèmes de valeurs cohérents »). Autrement dit: représentable par une fonction d’utilité.

Le papier confirme également ce que l’on savait déjà, qu’une IA plus intelligente a tendance à être moins « corrigible » (grosso-modo : influençable) qu’une moins intelligente.

Une grosse faiblesse du papier est qu’il n’étudie que les modèles après entraînement complet (y compris « respect de la hiérarchie des normes »), pas les modèles juste après l’entraînement uniquement sur la tâche de prédiction. En fonction de quand ce comportement apparaît, les implications sont très différentes.

(je ne m’essaierai même pas à traduire "Disempowerement", suggestions dans les commentaires bienvenues).

Dans le domaine de la sûreté des modèles, se pose (entre autres) la question de « et si on arrive à créer une IA qui surpasse l’être humain sur toutes les tâches cognitives… qu’est-ce qu’il se passe ? qu’est-ce qu’on fait ? est-on préparé à cette possibilité ? ».

Et on peut creuser dans la direction : comment réagira notre système social et économique actuel dans un monde où des IA superintelligentes sont accessibles à tous ? Reste-il une place pour les êtres humains dans l’économie ? Dans la politique, les sciences, les arts ?

La réponse me semble, et à d’autres, trivialement non. Étrangement (de mon point de vue), beaucoup semblent douter de ce non.

Une équipe de six chercheurs s’est donc attelée à formaliser un peu plus ce « non ». Présentation informelle ici, papier ici. Le résumé:

AI risk scenarios usually portray a relatively sudden loss of human control to AIs, outmaneuvering individual humans and human institutions, due to a sudden increase in AI capabilities, or a coordinated betrayal.

However, we argue that even an incremental increase in AI capabilities, without any coordinated power-seeking, poses a substantial risk of eventual human disempowerment.

This loss of human influence will be centrally driven by having more competitive machine alternatives to humans in almost all societal functions, such as economic labor, decision making, artistic creation, and even companionship.

Traduction :

Les scénarios de risque liés à l'IA décrivent généralement une perte relativement soudaine du contrôle humain au profit des IA, surpassant les humains individuels et les institutions humaines, due à une augmentation soudaine des capacités de l'IA ou à une trahison coordonnée.

Cependant, nous soutenons que même une augmentation progressive des capacités de l'IA, sans recherche coordonnée de pouvoir, présente un risque substantiel de privation éventuelle de pouvoir pour les humains.

Cette perte d'influence humaine sera principalement causée par l'émergence d'alternatives mécaniques plus compétitives que les humains dans presque toutes les fonctions sociétales, comme le travail économique, la prise de décision, la création artistique, et même les relations interpersonnelles.

C’est un papier significatif, parce que jusqu’ici les risques de perte de contrôle liés à l’IA étaient liés à plusieurs présuppositions dont beaucoup doutaient le caractère plausible: "l’IA n’est pas alignée", "différentes IA coopéreront contre les humains", "les IA se retourneront contre nous", "les IA arrêtent de suivre nos instructions", et autres hypothèses du même acabit.

Les auteurs arguent ici qu’aucune de ces conditions n’est nécessaire pour une perte de contrôle. La seule hypothèse nécessaire est essentiellement : « il existe des IA plus capables que le meilleur être humain » (et: nous gardons un système politique, social et économique proche de l’actuel).

Résumé rapide de l’historique :

- OpenAI a été fondé en 2015 comme un organisme sans but lucratif (que je raccourcirai par OSBL), dont Musk est un des fondateurs (et contributeur financier). La charte fondatrice est le développement de l’AGI "pour le bénéfice commun de toute l’humanité".

- Musk quitte OpenAI en 2018, pour des raisons non-communiqées.

- En 2019, l’OSBL créé une entreprise (donc à but lucratif), OpenAI Global LLC. L’OSBL (ou plus précisément: son conseil d’administration) reste la seule entité à contrôler l’entreprise, mais cela permet à l’entreprise d’attirer des investisseurs (contre promesses de dividendes sur les futurs profits).

- En 2023, éclate un conflit entre Sam Altman, le CEO de l’entreprise, et le conseil d’administration de l’OSBL, pour des raisons qui n’ont à ma connaissance jamais été communiquée. Sam Altman est renvoyé, les employés et investisseurs de l’entreprise prennent partie contre cette décision. Après quelques jours de tumultes, Sam Altman reprend sa place et le conseil d’administration remplacé.

- En 2024, Musk porte plainte contre OpenAI et Sam Altman, accusant l’entreprise de ne pas respecter la charte de l’OSBL. À ma connaissance, cette plaine est toujours en cours.

- Fin décembre 2024, l’entreprise déclare vouloir prendre son indépendance de l’OSBL. L’opération serait que l’entreprise rachète le contrôle de l’entreprise auprès de l’OSBL. Le bruit qui court pour ce rachat tourne autour de 40 milliards — après cet opération, OpenAI Global LLC serait indépendant de OpenAI l’OSBL, mais OpenAI l’OSBL aurait 40 milliards pour poursuivre sa mission de "développement de l’AGI.

Musk décide de mettre surenchérir, proposant l’acquisition pour 97 milliards (par un collectif d’investisseurs dont il est à la tête). Le conseil d’administration de l’OSBL refuse. Ceci met clairement un gros bâton dans les roues du plan de Sam Altman, car le conseil d’administration a toujours un devoir fiduciaire envers l’OSBL et sa charte. S’ils acceptent l’offre de 40 milliards de Sam Altman, tout en refusant celle de 97 milliards de Musk, il va falloir justifier que cette décision a été faite pour le bénéfice de l’OSBL, et le procureur de l’état de Californie pourrait bien regarder de plus près ces justifications, d’autant plus que Softbank serait sur le poins d’investir 40 milliards dans OpenAI… avec pour hypothèse de travail une valuation de 260 milliards de OpenAI Global LLC.

Zvi utilise l’expression « the greatest theft in human history » (le casse du siècle) pour cette opération d’émancipation. Au vu de ces informations (proposition pour 40 milliards, refus d’une autre à 97 milliards, valuation à 260 milliards), je ne trouve pas ça démérité.

Google publie les résultats d’une expérience "d’assistant scientifique IA"

L’annonce:

We introduce AI co-scientist, a multi-agent AI system built with Gemini 2.0 as a virtual scientific collaborator to help scientists generate novel hypotheses and research proposals, and to accelerate the clock speed of scientific and biomedical discoveries.

Given a scientist’s research goal that has been specified in natural language, the AI co-scientist is designed to generate novel research hypotheses, a detailed research overview, and experimental protocols.

To do so, it uses a coalition of specialized agents — Generation, Reflection, Ranking, Evolution, Proximity and Meta-review — that are inspired by the scientific method itself. These agents use automated feedback to iteratively generate, evaluate, and refine hypotheses, resulting in a self-improving cycle of increasingly high-quality and novel outputs.

Traduction:

Nous présentons l'IA co-scientifique, un système d'IA multi-agent construit avec Gemini 2.0 comme collaborateur scientifique virtuel pour aider les scientifiques à générer de nouvelles hypothèses et propositions de recherche, et pour accélérer la cadence des découvertes scientifiques et biomédicales.

Face à un objectif de recherche d'un scientifique spécifié en langage naturel, l'IA co-scientifique est conçue pour générer de nouvelles hypothèses de recherche, une vue d'ensemble détaillée de la recherche et des protocoles expérimentaux.

Pour ce faire, elle utilise une coalition d'agents spécialisés — Génération, Réflexion, Classement, Évolution, Proximité et Méta-évaluation — qui s'inspirent de la méthode scientifique elle-même. Ces agents utilisent des retours automatisés pour générer, évaluer et affiner itérativement des hypothèses, résultant en un cycle d'auto-amélioration produisant des résultats de plus en plus novateurs et de haute qualité.

Les premiers résultats semblent encourageants:

We applied the AI co-scientist to assist with the prediction of drug repurposing opportunities and, with our partners, validated predictions through computational biology, expert clinician feedback, and in vitro experiments.

Notably, the AI co-scientist proposed novel repurposing candidates for acute myeloid leukemia (AML). Subsequent experiments validated these proposals, confirming that the suggested drugs inhibit tumor viability at clinically relevant concentrations in multiple AML cell lines.

Traduction:

Nous avons appliqué l'IA co-scientifique pour aider à la prédiction d'opportunités de repositionnement de médicaments et, avec nos partenaires, validé ces prédictions par la biologie computationnelle, les retours d'experts cliniciens et des expériences in vitro.

Notamment, l'IA co-scientifique a proposé de nouveaux candidats de repositionnement pour la leucémie myéloïde aiguë (LMA). Des expériences ultérieures ont validé ces propositions, confirmant que les médicaments suggérés inhibent la viabilité tumorale à des concentrations cliniquement pertinentes dans plusieurs lignées cellulaires de LMA.

Également:

As a third validation, we focused on generating hypotheses to explain bacterial gene transfer evolution mechanisms related to antimicrobial resistance (AMR) — microbes' evolved mechanisms to resist infection-treating drugs. This is another complex challenge that involves understanding the molecular mechanisms of gene transfer (conjugation, transduction, and transformation) alongside the ecological and evolutionary pressures that drive AMR genes to spread.

For this test, expert researchers instructed the AI co-scientist to explore a topic that had already been subject to novel discovery in their group, but had not yet been revealed in the public domain […].This in silico discovery, which had been experimentally validated in the original novel laboratory experiments performed prior to use of the AI co-scientist system, are described in co-timed manuscripts (1, 2) with our collaborators at the Fleming Initiative and Imperial College London. This illustrates the value of the AI co-scientist system as an assistive technology, as it was able to leverage decades of research comprising all prior open access literature on this topic.

Traduction:

Comme troisième validation, nous nous sommes concentrés sur la génération d'hypothèses pour expliquer les mécanismes d'évolution du transfert de gènes bactériens liés à la résistance aux antimicrobiens (RAM) — les mécanismes développés par les microbes pour résister aux médicaments traitant les infections. Il s'agit d'un autre défi complexe qui implique la compréhension des mécanismes moléculaires du transfert de gènes (conjugaison, transduction et transformation) ainsi que des pressions écologiques et évolutives qui conduisent à la propagation des gènes de RAM.

Pour ce test, des chercheurs experts ont demandé à l'IA co-scientifique d'explorer un sujet qui avait déjà fait l'objet d'une découverte nouvelle dans leur groupe, mais qui n'avait pas encore été révélé dans le domaine public […]. Cette découverte in silico, qui avait été validée expérimentalement dans les expériences de laboratoire originales effectuées avant l'utilisation du système d'IA co-scientifique, est décrite dans des manuscrits publiés simultanément (1, 2) avec nos collaborateurs de la Fleming Initiative et de l'Imperial College London. Cela illustre la valeur du système d'IA co-scientifique en tant que technologie d'assistance, car il a pu tirer parti de décennies de recherche comprenant toute la littérature en libre accès antérieure sur ce sujet.

Un des chercheurs impliqué dans le projet (côté biologie, pas IA), le professeur José R. Penadès partage son impression:

It's not just that the top hypothesis they provide was the right one. It's that they provide another four, and all of them made sense. And for one of them, we never thought about it, and we're now working on that.

Traduction:

Ce n'est pas seulement que l'hypothèse principale qu'il fournit était la bonne. C'est qu'il en propose quatre autres, et toutes avaient du sens. Et pour l'une d'entre elles, nous n'y avions jamais pensé, et nous travaillons maintenant dessus.

Autres news diverses et variées

Une IA entrainée sur la totalité du génome (connu) du règne vivant. Open-source (à la fois le code, les données d’entrainement, et le modèle résultant). Peut être utilisé, par exemple, pour prédire par exemple l’effet (bénéfique ou néfaste) d’une mutation.

Emergent Misalignment: Narrow finetuning can produce broadly misaligned LLMs: une expérience qui montre que ré-entrainer une IA (avec une phase de fine-tuning) à faire une tâche usuellement considérée comme un mauvais usage (générer du code contenant des failles de sécurité) incite l’IA à effectuer des tâches non désirables dans des domaines complètement différent (encouragement au meurtre, apologie du nazisme). C’est considéré comme une bonne nouvelle: cela réduit la possiblité qu’une IA clairement bénéfique dans beaucoup de domaines soit "secrètement" néfaste dans d’autres domaines non évalués.

Google propose un accès API à ses meilleurs modèles publics (Gemini 2.0).

En janvier, DeepSeek a fait couler de l’encre en publiant un modèle proche de l’état de l’art avec un coût d’entraînement présenté comme extrêmement faible. SemiAnalysis affirme que le coût reporté de 6 millions ne reflète que le coût marginal et ne prend pas en compte le coût total (en comptant entre autre : R&D, investissement en matériel). Le vrai chiffre serait plus proche de 1,3 milliards.

Nouveau papier sur la défense contre les jailbreaks par Anthropic: Constitutional Classifiers: Defending against universal jailbreaks. Anthropic lance le 3 février une compétition pour trouver des contournements à cette défense. Dix jours plus tard, la compétition est remportée.

Une avancée dans le domaine des robots humanoïdes, découpant le contrôle du robot en deux sous-systèmes, un système lent basé sur un LLM, et un système rapide qui prend une représentation intermédiaire du premier système pour générer rapidement des actions motrices.

Google abandonne sa promesse de ne pas utiliser l’IA dans le domaine militaire ou de la surveillance.

Le Gouvernement annonce la création de l’Institut national pour l’évaluation et la sécurité de l’intelligence artificielle (INESIA).

Deux pointures de l’IA, Geoffrey Hinton et Yoshua Bengio débatent (oui, sur Facebook) sur "les IA actuelles sont-elles déjà conscientes ?"

Trump lance un "Projet Manhattan" pour des applications militaires à l’IA. Dont un des axes de développement serait la création de "robots-tueurs autonomes".

Une modeste proposition sur une stratégie raisonnable de développement de l’IA dans un futur proche.

Démonstration de Gemini Live, partagez votre écran avec l’IA pour qu’elle vous guide.

Démonstration des "Interactive Artifacts", demandant à Claude une simulation interactive pour convaincre l’utilisateur de ne pas lancer Civilization VII.

The Anthropic Economic Index, ou: quelle place a déjà l’IA dans l’économie ?

Humane AI ferme, rachetés par HP.

OpenAI met à jour son modèle 4o, réactions plutôt positives sur les résultats. Parmi les changements: "GPT-4o fait maintenant un usage plus élevé des emoji". Merci mais non merci ?

Comme l’IoT, le S dans "Agent" veut dire sécurité. Si votre agent IA visite un site malicieux, ce dernier peut prendre contrôle de votre agent pour, par exemple, divulguer vos informations personnelles ou envoyer des mails malicieux (démonstration, papier).

Mira Murati, ex-CTO d’OpenAI, lance son entreprise d’IA, Thinking Machines.

Nouveau benchmark, EnigmaEval. Aucune IA actuelle ne fait au dessus de 0% sur la plus haute difficulté.

Également ZeroBench, dans le domaine de la vision par ordinateur, où les IA actuelles font aussi 0%. J’avoue ne pas être bien au-dessus des IA actuelles, au vu des échantillons.

Autre benchmark, SWE-Lancer. Benchmark intéressant et atypique, car il n’est pas mesuré en taux de réussite sur des tâches abstraites et théoriques, mais en espèces sonnantes et trébuchantes. C’est un ensemble de tâches de programmation réelles tirées de la plateforme de freelancing Upwork. Le total des tâches fait 1 million de dollars. Le total des tâches réalisables par les modèle actuels (Sonnet, o1) tourne autour de 40% (400,000 dollars).

OpenAI continue à essayer de faire des signes vers l’Open-Source.

Papiers divers notables :

Pour aller plus loin

Non couvert, mais si vous trouvez que ce journal n’est pas suffisamment long, faites vous plaisir :

En audio/vidéo (anglais uniquement) :

Commentaires :

voir le flux Atom

ouvrir dans le navigateur